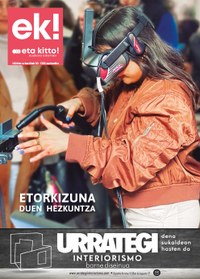

Eneko Agirre: "Euskarazko adimen artifiziala entrenatzeko testu masa erraldoiak behar dira"

Adimen artifizialak euskararengan izango duen eraginaz eta ditugun erronkez hitz egin zuen Eneko Agirre informatikari eibartarrak aurreko astean UEUren 2023/2024 ikasturtearen hasiera ekitaldian. Eneko Agirre Euskal Herriko Unibertsitateko irakasle osoa eta Ixa Taldeko kidea da. Informatika Fakultatean lan egiten du 1988tik, Lengoaia eta Sistema Informatikoak sailean, eta euskararen prozesamendu automatikoa lantzen duen HiTZ zentroko zuzendaria da. HiTZ erreferentziazko zentroa da Hizkuntza Teknologietan. Helburua du ikerketa, prestakuntza, transferentzia teknologikoa eta berrikuntza sustatzea hizkuntza eta ahotsa ardatz duten adimen artifizialean. Diziplina anitzeko taldea da: informatikariak, hizkuntzalariak eta ingeniariak. Ixa eta AhoLab ikerketa-taldeek osatzen dute HiTZ zentroa.

Chat GPT teknologiak bere sorkuntzatik harrituta utzi gaitu, komunikatzeko duen gaitasunagatik. Pantailaren bestaldean gizaki bat dagoela dirudi eta hori txundigarria bezain beldurgarria da. Eneko Agirreren esanetan, “Chat GPT izan da inoiz egon den erabilera handiena lortu duen aplikazioa eta webgunea, egun gutxitan eta propaganda egin gabe. Jendea berehala hasi zen erabiltzen eta txundituta zegoen. Ikerlariontzako ere zaila izaten ari da aplikazioa lortzen ari den irismena ulertzea". Adimen artifizialaren kontua izkina guztietara iritsi dela dio Agirrek: "Dagoeneko ez da bakarrik laborategietan dagoen gauza bat, gizartean dago eta ezin da ukatu gauza kezkagarriak egon badaudela”.

GPT teknologia (Generative Pre-trained Transformer) adimen artifizialean oinarritutako hizkuntza-eredu mota bat da, OpenAIk garatua. Teknologia hori giza testua modu koherentean ulertzeko eta sortzeko duen gaitasunagatik nabarmentzen da. “Hizkuntza-eredu deitzen dira gai direlako hizkuntza probabilitateen edo hizkuntza batean gertatzen diren gauzen eredu matematiko bat egiteko”, azaldu zuen Agirrek.

Adimen artifizialeko hizkuntza-ereduak sistema konputazionalak dira, giza hizkuntza modu naturalean ulertzeko eta sortzeko diseinatuak. Eredu horiek lengoaia naturalaren prozesamenduarekin lotutako aplikazio eta teknologia askoren funtsezko zati dira, eta aplikazio sorta zabala dute, laguntzaile birtualetatik hasi eta itzulpen automatikoetaraino, testuaren sorkuntza, testu-laburpena, txatbot-ak eta askoz gehiago.

Hurrengo hitza nola iragarri

Hizkuntza-ereduaren atzean dagoena zer den azaldu zuen Agirrek, “garrantzitsua delako nola funtzionatzen duen ezagutzea. Atzean dagoen ideia da makinari erakustea nola iragarri hurrengo hitza. Horretarako bi gauza behar dira: alde batetik, testu masa erraldoiak makinak entrenatzeko, irakasteko; eta sare neuronal berezi batzuk, bestetik. Guretzako hau oso aspergarria da, baina makinak pazientzia izugarria dauka. Oso sinplea dirudi, hurrengo hitza zein den asmatzearen jokoa dirudi, baina gauza asko jakin behar dira. Prozesu horretan, Interneteko testu ugarirekin elikatzen da sarea, eta aurreko hitzen sekuentzia baten araberako perpaus batean hurrengo hitza iragartzeko eskatzen zaio. Horrek aukera ematen dio GPT-ri gramatika, perpausen egitura, munduaren ezagutza orokorra eta lotura semantikoak ikasteko. Arazoa zein da? Testu masa handiak behar direla", dio ikerlariak.

Hala ere, makinek sortutakoaren atzean pertsonak daude beti –ezinbesteko duen datu-basea osatzen dabiltzanak–. Robota nahiko adimentsu izateko bidean, oinarrian behar dituelako klikatzen, etiketatzen, esaldiak berridazten, informazio sinpleak sortzen ariko diren pertsonak.

Marka guztiak hautsita

Agirrek dio izugarria dela, marka guztiak hautsi zituela GPTk:"Benetan ematen du pertsona bat dagoela atzean pentsatzen dituen gauzak esaten. Udaletxe bateko teknikari batek pliegoak idazteko Chat GPT erabiltzen duela badakit. Idazlanak, testu administratiboak, galdera-erantzunak, elkarrizketa sistemak (badago enpresa bat pedido osoak makina batekin egiten dituenak)... Eta hortik etorri da gauza asko pertsonak baino hobeto egiten dituela, akats gutxiagorekin. Gauza asko egiten ditu, egia da, baina mundua suntsitzerik ez dut ikusten (azken aldian asko hitz egiten ari da ideia horretaz)".

Benetazko arriskuak

Sistema hauen erabilera asko hedatzen ari da eta errore asko egiten ditu. "Hain ondo idazten du ezen badirudi badakiela zer dioen. Ba, ez fidatu, ondo begiratu behar dira testu horiek. Eta badaude beste arazo batzuk: bazterketaren arazoa (genero edo arrazari dagozkionak esaterako), desinformazioaren hedapen masiboa, enpleguak ezabatzeko aukera,gizartearen eraldaketa (hezkuntzan, adibidez), energiaren kontsumo altua... Eta ezin dugu ahaztu botere kontzentrazioa: oso enpresa gutxiren esku dago informazioarekin zerikusia daukan teknologiarik ahaltsuena. Gauza guzti horiek hor daude. Eta horregatik dago suntsiketarena, entretenitzeko eta horrelako gauzetaz gutxiago hitz egiteko".

Zer egin euskararentzako

"Nola erabaki dezakegu horrelako zerbait euskararentzako? Egin behar dugun bideak ezinbestean oinarritu behar du baliabide irekietan eta publikoetan”, uste du eibartarrak. Geure tresna propioak garatu behar ditugula eta ikerlari gehiago behar direla dio Agirrek. "Konputazioan orain dela urte batzuk baino medio gehiago ditugu (Eusko Jaurlaritzak dirulaguntzak eman ditu), baina ez da nahikoa", dio.

Bestalde, egungo eta etorkizuneko teknologiek testuzko eta ahozko datu masa erraldoiak eskatzen dituzte hizkuntza bakoitzeko, eta, aldiz, euskarak eskaini ahal dituen datuak ez dira nahikoak teknologia horiei etekina ateratzeko, eta gailu horiek behar adina kalitate eskaintzeko. Enekok esan zuenez, "testu masa erraldoiak behar dira euskaraz, aplikazioek ondo funtzionatu dezaten. GPT 3k 500.000 milioi hitz ditu eta guk 1.000 aldiz gutxiago. Testu asko lortu ditugu hainbat euskal hedabideetatik eta wikipediatik, baina hori gutxi da. Kalitate ona nahi badugu, gazteleraren parekoa, behar dugu ekimen bat testu masa erraldoiak ekartzeko. Eta ekimen horretan administrazio eta enpresa pribatuen eskuzabaltasuna beharko dugu”, esan zuen Enekok.

Beste aukera, multinazionalen zain egotea da. Baina, kasu horretan, “teknologiaren jabego eta kontrola non gelditzen da? Ez da hizkuntza kontua bakarrik, kultura ere bada. Azken finean hau wikipediaren parekoa izango da, jendeak zuzenean galdetuko dio sistema horri”, dio ikertzaileak.